DATEN ERFASSEN UND AUSWERTEN

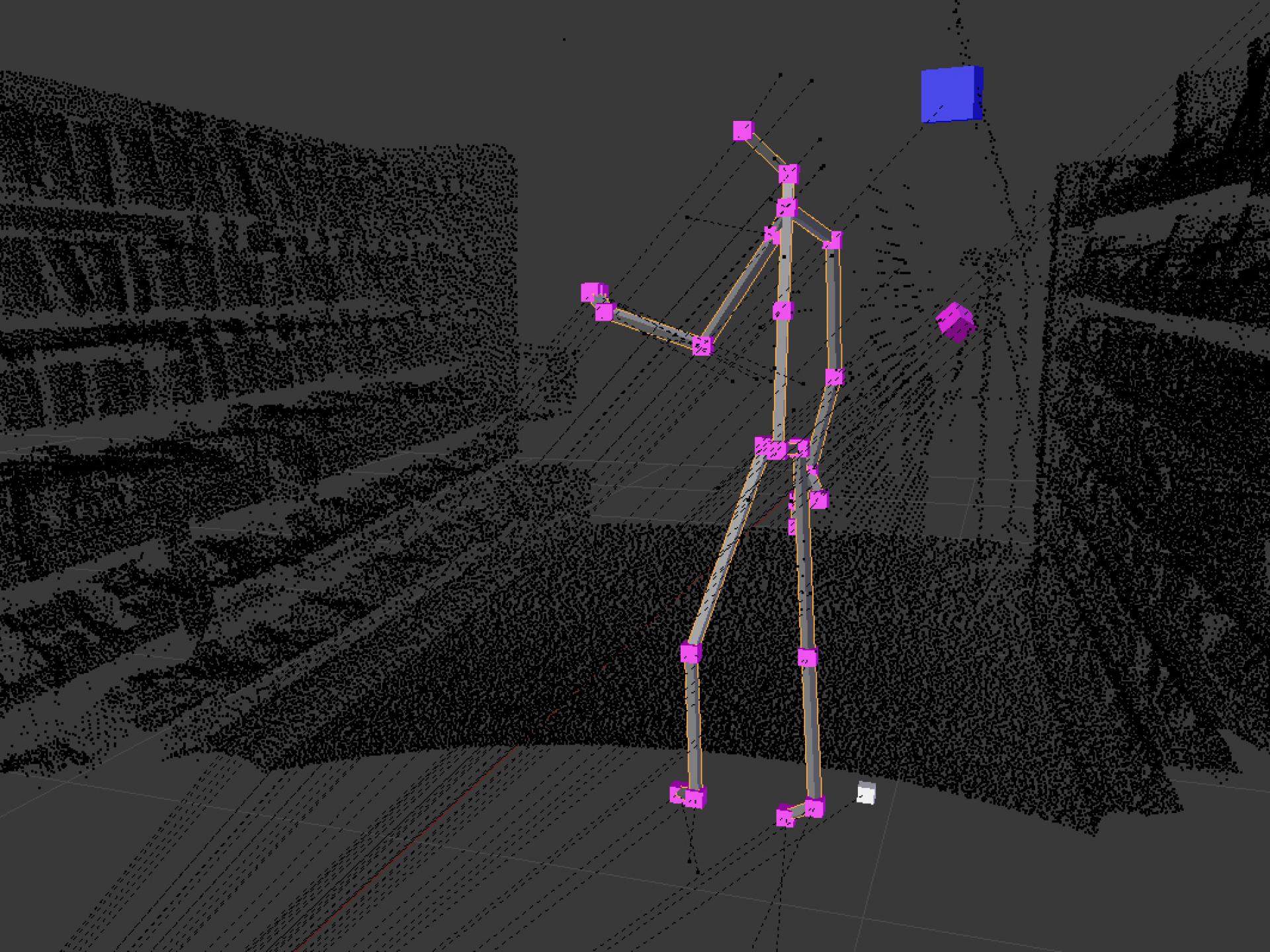

Im Raum werden Sensoren aufgestellt. Ein Laserscanner erstellt mittels einer oder mehrerer fusionierter 3D-Punktewolke Aufnahmen eine 3D Repräsentation der realen Umgebung.

Am Probanden selbst befindet sich ein mobiles Sensor System. In der Kombination werden Positionen, Posen, Mimik, Gestik und Hautleitwert zeitlich synchronsiert erfasst und ausgewertet.

Zur Auswertung kommen unter anderem Deep Learning Methoden, OpenCV Funktionen, Kinect 2 SDK Funktionen und weitere Frameworks von Drittanbietern zum Einsatz. Alle Sensoren werden zueinander in Beziehung gesetzt und in der 3D Repräsentation verortet.

POSITION, GESTIK UND MIMIK DES PROBANDEN BESTIMMEN

Mittels Eye-Tracking wird die Blickrichtung des Probanden im Raum festgestellt. Ein Sensor zur Messung des Hautleitwerts dient zur Einschätzung des aktuellen Stresslevels.

Je nach Größe und Beschaffenheit des realen Raumes erfassen mehrere Kombinationen aus Gigabit Ethernet Kameras und Kinect 2.0 Sensoren den Probanden aus unterschiedlichen Blickwinkeln. Daraus können seine Position, Gestik und Mimik bestimmt werden.

Zusätzlich können an Hotspots weitere Farbkameras aufgestellt werden, um die Mimikauswertung an diesen Positionen genauer zu erlauben. Alle Sensoren werden in die 3D Repräsentation aus den Laserscans kalibriert.

3D Position Tracking

Auf Basis mehrerer Gigabit Ethernet Kameras und mehrerer Kinect 2.0 Sensoren wie auch auf den fusionierten Ergebnissen beider werden Personen in realen Räumen in Echtzeit getrackt.

Sensor Datenfusion

Die Daten von Kinect 2.0 Sensoren, Gigabit Ethernet Kameras, 3D Laserscans, Farbkameras zur Mimik Erkennung, Sensoren zur Hautleitmessung werden fusioniert, zeitlich synchronisiert und räumlich zueinander in Beziehung gesetzt.